Avantages : Ce rapport offre aux utilisateurs la possibilité de mieux comprendre et gérer l’indexation de leurs sites, permettant ainsi une optimisation plus efficace du référencement. La transparence et la profondeur des informations fournies sont sans précédent et permettent une gestion plus précise du SEO.

Analyse du nouveau rapport Robots.txt

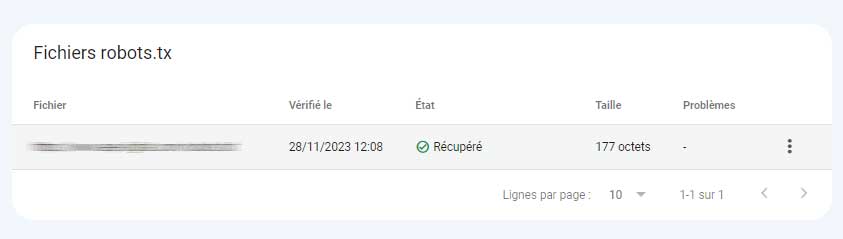

Le nouveau rapport dédié aux fichiers robots.txt dans la Google Search Console est une avancée significative pour les experts en SEO et les gestionnaires de sites web. Il offre un accès immédiat à des informations détaillées et cruciales, facilitant ainsi le diagnostic et la résolution rapide des problèmes d’indexation. Cette fonctionnalité permet de visualiser quels fichiers robots.txt ont été identifiés par Google, la date de leur dernière exploration, ainsi que les erreurs ou avertissements associés.

Points Clés:

- Accès aux données détaillées sur les fichiers robots.txt.

- Possibilité de demander une nouvelle analyse d’un fichier robots.txt en cas de modifications urgentes.

- Identification rapide des erreurs ou des avertissements pour une action corrective efficace.

Implications : Ces fonctionnalités avancées sont particulièrement utiles pour les professionnels du SEO, car elles offrent une compréhension plus profonde de la manière dont les fichiers robots.txt affectent l’indexation et le référencement. La capacité de demander une nouvelle analyse après des modifications urgentes est un atout majeur, permettant de s’assurer que les changements sont rapidement pris en compte par Google.

Suppression du testeur Robots.txt

L’introduction de ce nouveau rapport dans la Search Console a conduit Google à prendre une décision importante : la suppression de l’ancien outil de test des robots.txt. Auparavant, cet outil permettait aux utilisateurs de vérifier si le fichier robots.txt empêchait les robots de Google d’explorer certaines URL spécifiques. Toutefois, avec les capacités étendues et les fonctionnalités avancées du nouveau rapport, l’outil de test devient redondant.

Changements Importants :

- Retrait de l’ancien outil de test des robots.txt.

- Les fonctionnalités du nouvel outil rendent l’ancien obsolète.

- Suppression programmée pour le 12 décembre 2023.

Conséquences : Cette évolution souligne l’engagement de Google à fournir des outils plus efficaces et intégrés pour aider les webmasters à optimiser leurs sites pour le référencement. Elle marque un pas en avant vers une plateforme plus unifiée et efficace pour la gestion des aspects techniques du SEO.

Rapport ROBOTS.TXT : nouvelles fonctionnalités et implications

Le rapport robots.txt de la Google Search Console offre désormais des fonctionnalités étendues pour une gestion optimale des fichiers robots.txt. Il fournit des informations précieuses sur les fichiers robots.txt trouvés pour les principaux hôtes d’un site, incluant la date de la dernière exploration, ainsi que les erreurs et les avertissements détectés. De plus, il permet de demander une nouvelle exploration d’un fichier en cas de modifications importantes, garantissant ainsi que les changements sont rapidement pris en compte.

Fonctionnalités Avancées :

- Surveillance des fichiers robots.txt pour les principaux hôtes d’un site.

- Identification des erreurs et des avertissements pour une action corrective rapide.

- Possibilité de demander une nouvelle exploration en cas de modifications majeures.

Implications pour les Utilisateurs : Cette fonctionnalité est particulièrement utile pour les propriétés au niveau du domaine. Elle simplifie la gestion des fichiers robots.txt sur différents hôtes et sous-domaines, permettant aux webmasters de se concentrer davantage sur d’autres aspects du référencement. L’outil facilite la conformité aux directives de Google et aide à maintenir une présence en ligne optimisée.